ETH-X Scale Up协议:支持高性能内存访问的互联协议

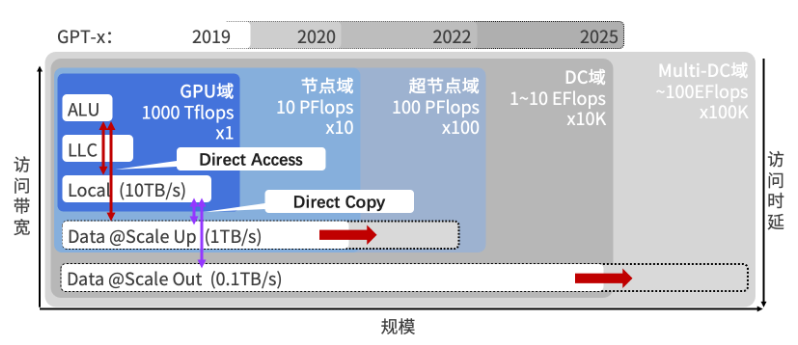

2024-12-30随着GPU服务器架构从单机单卡演进至包含数十乃至数百个GPU的大规模超节点形态,跨GPU高效数据访问的需求显著增加。为此,通过Scale-Up网络实现了GPU间的直接互联,以支持高效的数据交换需求。GPU间的通信域已从单机内的总线域(Bus Domain)扩展到包含数十乃至数百个GPU的超节点内“Scale-Up”域。与传统的总线域和机间互联(Scale-Out域)相比,“Scale-Up”域具有显著差异,不仅需要处理TBps级别的高效互联需求,而且尽管其性能接近总线域,但在规模和技术复杂度上远超前者,部分技术挑战与Scale out域相近。因此,在协议设计方面,“Scale-Up”域面临新的挑战,促使其需重新思考与设计。

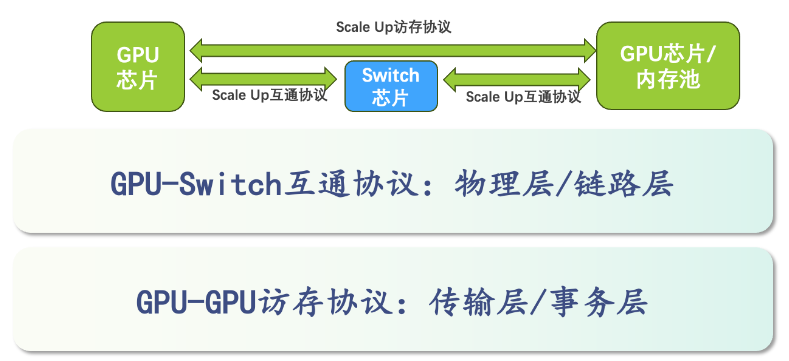

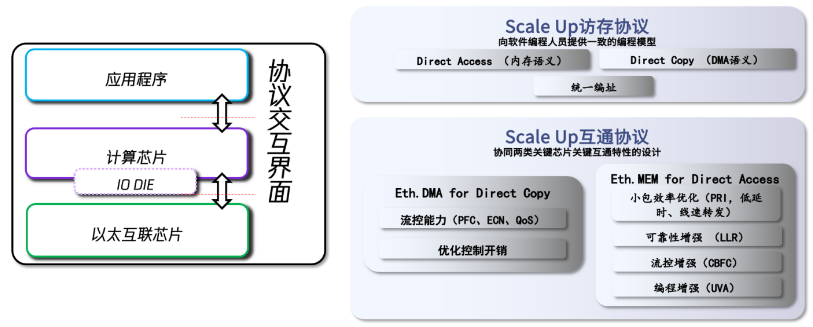

ETH-X方案中提出,Scale Up互联协议应根据GPU-Switch间的互通需求及GPU-GPU间的访存需求来分层实施。其中,GPU-GPU间的访存协议需向应用层提供直接拷贝(Direct Copy)、直接内存访问(Direct Access)及统一编址(UVA)等语义,事务通信方式及格式由GPU闭环设计与实现。而GPU-Switch间的互通协议应基于ETH交换芯片能力,通过ETH.DMA和ETH.MEM两类能力集合,满足上层的Direct Copy和Direct Access传输需求。

“AI算力”需求正持续增长

随着大模型的快速发展,AI模型对集群算力的需求呈现指数级增长,现有的数据中心算力已不能满足超大模型运算的要求。当前算力需求的增长主要体现在集群总合成算力扩张和单节点有效算力扩张两个方面。为应对这些挑战,Scale-Out域通过互联多个数据中心,提升了单个任务可用的总计算能力。而Scale-Up域通过超高带宽将更多算力芯片紧密互联,增强了单节点的算力资源,从而容纳运行更大、更胖、更宽的模型进行训练和推理。

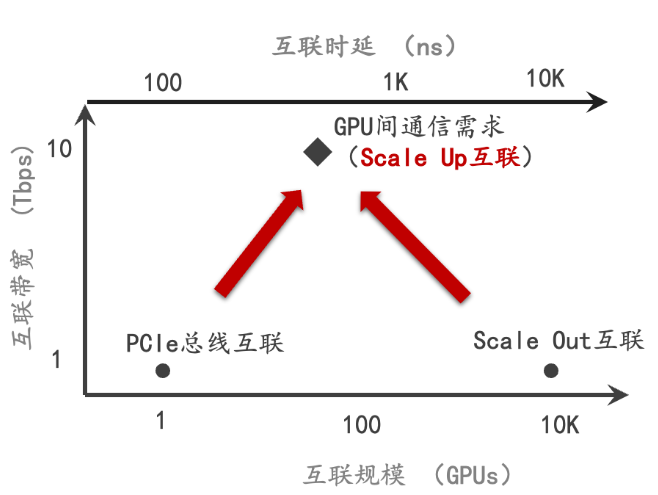

Scale Up 互联需求与现有技术的差距

在Scale Up场景中,对互联时延的要求严苛,需达到百纳秒级别,现行的Scale Out互联技术时延高达10微秒,远超这一标准。在互联带宽方面,Scale Up域需要进行数百个GPU间10Tbps带宽级别的互联;相较之下,现有PCIe总线和Scale Out互联技术仅能提供Tbps级别的带宽,显然无法满足需求。当前Scale Up的通信需求与现有技术之间存在明显的不匹配。为应对未来高性能计算的挑战,亟需研发创新技术,旨在实现更低的延迟和更高的带宽,满足日益增长的Scale Up通信需求。

Scale Up 互联的协议分层

协议分层是一种简化复杂系统设计的有效策略,通过将整个系统分解为多个专注于特定功能的小部分,从而降低整体复杂度并控制难度。各层协议可以独立开发、调试和维护,进而提高了工作效率。此外,分层结构也是标准化的催化剂,清晰地界定了各层的功能特性,为制定标准提供了坚实的基础,并促进了系统间的互操作性和兼容性。

Scale Up域的分层策略

一般总线系统可以将协议分为三或四个(物理层、链路层、传输层、事务层)层次进行设计:

物理层(Physical Layer):物理层是协议的最底层,主要负责数据的物理传输。

链路层(Data Link Layer):链路层位于物理层之上,负责数据的分包和链路管理。

传输层(Transport Layer):传输层负责管理数据的传输控制和流量管理。

事务层(Transaction Layer):事务层是协议的最高层,负责处理数据的逻辑传输。

Scale Up域将协议划分为两个功能集:

GPU-Switch互通协议。在 GPU 与 Switch 之间依赖物理层和链路层进行协议互通,满足数据在网络中正确传输、转发和流控。ETH-X建议利用现有的交换芯片以实现GPU与Switch之间的互通,并对此进行改进,以提高网络在可靠性和流量控制方面的性能。这样的优化措施为GPU的IO设计提供了简化的空间。

GPU-GPU访存协议。作为GPU之间实现内存访问的基础机制,该协议依赖于传输层与事务层,旨在满足访存事务的封装、解析、流量控制、可靠传输以及顺序保障等需求。在Scale Up域内,由于GPU采用同构设计,ETH-X项目的访存协议实现可由GPU厂商独立完成,以根据应用场景实现设计与实现的闭环。

GPU-Switch协议:芯片的互通需求

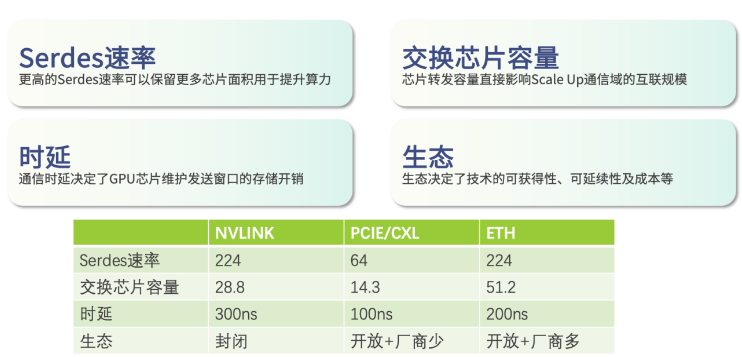

在优化Scale Up互联决策时,需考虑多个关键因素,确保所选技术既满足当前需求又具备良好的扩展性。以下是对各因素的简洁阐述:

1.较高的Serdes速率意味芯片可以节省物理层的面积开销。

2.交换芯片容量决定互联规模,高容量芯片支持更多GPU互联。

3.通信时延影响GPU维护通信状态的存储开销和计算效率,以及有效的通信带宽。

4.生态系统成熟度关乎技术的易获取性、可持续性和成本。开放多厂商支持的生态系统提供更多选择,降低成本,并保障长期稳健发展。封闭生态系统虽短期可能更佳,但限制扩展性和成本效益。

综上因素相互关联,共同影响Scale Up互联技术的选择和实施效果。

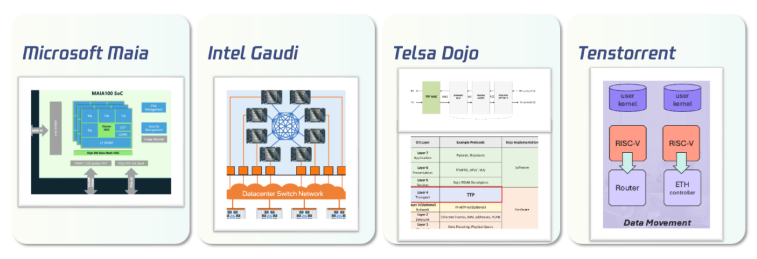

业界使用ETH构建Scale Up网络

GPU-GPU协议:应用的访存方式与需求

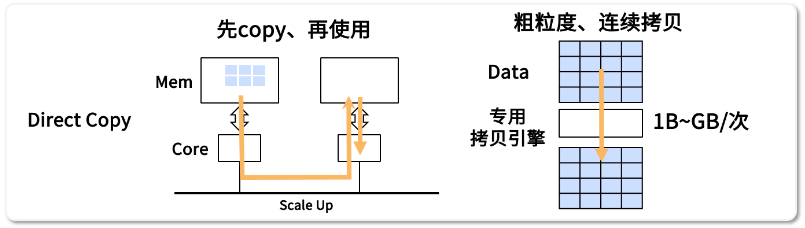

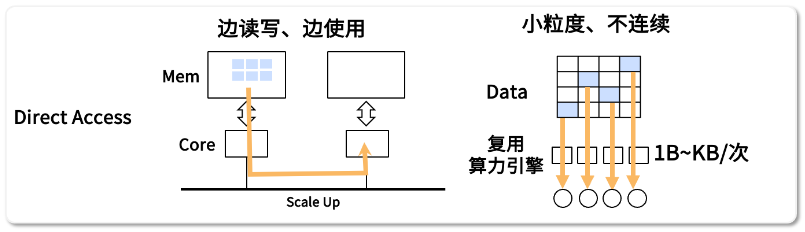

应用访问远端数据时有两种使用模式:Direct Copy (先拷贝,后使用),Direct Access (边读写,边使用)。

直接拷贝 Direct Copy:先拷贝,后使用

Direct Copy示意图

针对大规模连续数据传输与处理的场景,使用Direct Copy的方式可以大批量地将数据从远端HBM直接拷贝至本地HBM中,随后计算引擎再将数据加载到寄存器中进行使用。

直接拷贝的访存特点是允许粗粒度大范围的连续数据存取,其每次访问的数据量介于单字节至数兆字节范围。拷贝后的数据存放于本地内存中,可以供后续操作充分多次利用。这种方式依托专用硬件(如DMA引擎)进行数据拷贝,从而有效减轻CPU负担,并特别适合高效处理结构化数据,实现高效的批量处理。

然而,由于涉及大数据块的硬件拷贝操作,此流程启动延迟相对较高;并且对一些非结构化(非连续)的数据进行操作前,必须提前进行预处理将数据重新编排,从而引入额外的开销。因此直接拷贝的方式并不适合非结构化、细粒度的数据访问模式。

直接访问 Direct Access:边读写,边使用

Direct Access示意图

直接访存(Direct Access)允许计算引擎从远端HBM存储中直接读写数据,并将这些数据加载至寄存器中,在后续运算中立即使用。

直接访存的特点是允许小粒度、非连续的数据访问,数据规模通常介于1字节至千字节之间。访问操作由内部算力引擎直接发起,通过多个算力引擎可实现大批量的、离散的数据的并行访问,这种方式无需引入外部控制流程,因此特别适用于高效处理大量非结构化的细粒度数据访问。

然而,由于算力引擎在访问存储器时存在一定程度的同步等待机制,处理流程可能在数据读写未完成之前暂时挂起,这可能导致计算资源的潜在空转,从而未能充分利用计算资源。因此,访存任务的响应时延对于整体通信与计算的效率具有至关重要的影响。

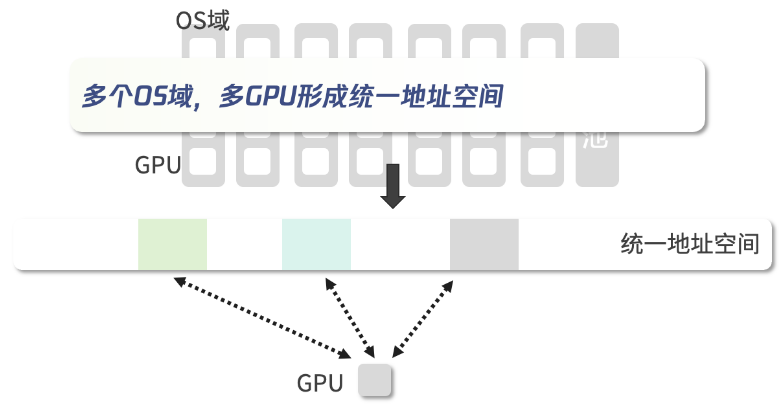

统一编址能力(Unified Virtual Address)

统一内存编址技术允许GPU共享同一个虚拟地址空间,使得多个GPU可以直接互相访问对方的内存,它通过硬件级别的页表同步来实现内存地址的统一管理,从而大大简化了异构计算编程模型。在大规模深度学习训练中,模型参数和中间结果可以在多个GPU显存间灵活分配和共享,提升了显存利用效率。UVA同时简化了编程模型,开发者可以像操作单个大容量显存一样使用多GPU系统,而不必关心复杂的数据移动细节。此外,该技术还支持细粒度的页面迁移,允许根据访问模式智能地将数据放置在最优的存储位置。

UVA机制示意图

典型的RDMA引擎的实现需要支持在动态环境中通过链接建立、内存注册等机制获取对端节点的内存访问权限,这些能力的实现在硬件中引入了巨大的开销。借助UVA地址空间管理Scale Up域GPU显存的访问权限,RDMA引擎无需动态建立连接的过程,亦无需在运行时建立内存映射关系甚至Pin住内存以获得访问权,因此其实现可以得到简化。

ETH-X Scale Up互联协议的建议

ETH-X Scale Up互联协议示意图

ETH-X建议的Scale Up互联协议涉及的交互界面包含应用程序、计算芯片以及以太互联芯片这三种实体。计算芯片为应用程序提供Direct Copy和Direct Access两种访问存储语义接口,以满足数据通信的需求。交换芯片则向计算芯片提供ETH.DMA和ETH.MEM两种能力集合,分别支持Direct Copy和Direct Access访问存储语义。

关于Direct Copy语义,其核心关注点在于网络是否能高效利用带宽。DMA引擎被用于实现Direct Copy语义,如Nvlink域中的专用CE引擎、Ethernet域中的RoCE引擎等。然而作为以太协议上当前的较为成熟DMA引擎实现,RoCE引擎设计实现需要兼容软件层verbs语义,其交互方式(WQ、CQ)与位于CPU侧的控制路径都引入了较大的实现开销,直接作为Scale Up域的解决方案不是最优解。Scale Up互通协议中的Eth.DMA能力集合,提供关键的流量控制能力(如PFC、ECN、QoS等),支撑网络运行在无损状态,同时提出对RoCE引擎实现开销进一步优化的方案。

对于Direct Access语义,其不仅关注网络的利用效率,还要求网络能够营造一个确定的低时延传输环境。交换机主要通过提供Eth.MEM能力集合来支持Direct Access通信。该集合包含小包传输效率优化技术(例如PRI技术、芯片转发时延优化等)、可靠性增强技术(通过LLR链路层重传技术优化错误包导致的尾时延增加)以及主动式的流控增强技术(采用CBFC主动式信令控制优化拥塞导致的尾时延增加)。

小结

针对Scale Up域在协议设计上面临的新挑战和需求,ETH-X项目方案中提出GPU应向上层应用提供直接拷贝(Direct Copy)、直接内存访问(Direct Access)及统一编址(UVA)等语义。GPU与Switch间的互通协议应基于ETH交换芯片能力,以ETH.DMA和ETH.MEM两类能力集合分别支持上层Direct Copy和Direct Access的传输需求。

联系人

腾 讯 张老师 13620187928

信通院 孙老师 15732071244

- 关注我们

-

- 联系我们

- 中国信通院云大所 数据中心团队